Xiaomi vừa chính thức ra mắt mô hình Trí tuệ nhân tạo mã nguồn mở đầu tiên của hãng, đánh dấu bước tiến chiến lược trong cuộc đua công nghệ AI toàn cầu. Đây không chỉ là nỗ lực nhằm khẳng định vị thế của Xiaomi trong lĩnh vực trí tuệ nhân tạo, mà còn cho thấy xu hướng ngày càng mở rộng và minh bạch của các công nghệ AI hiện đại. Cùng Phong Vũ Tech News xem qua chi tiết về mô hình AI mã nguồn mở này trong bài viết dưới đây!

I. Xiaomi chính thức gia nhập cuộc đua LLM với MiMo-7B

Xiaomi âm thầm ra mắt MiMo-7B – mô hình ngôn ngữ lớn (LLM) mã nguồn mở đầu tiên của hãng, đánh dấu bước ngoặt trong hành trình tiến sâu vào lĩnh vực trí tuệ nhân tạo. Đây là thành quả của đội ngũ Big Model Core Team mới thành lập, với trọng tâm phát triển đặt vào khả năng suy luận, một trong những thách thức lớn nhất của các mô hình ngôn ngữ hiện đại.

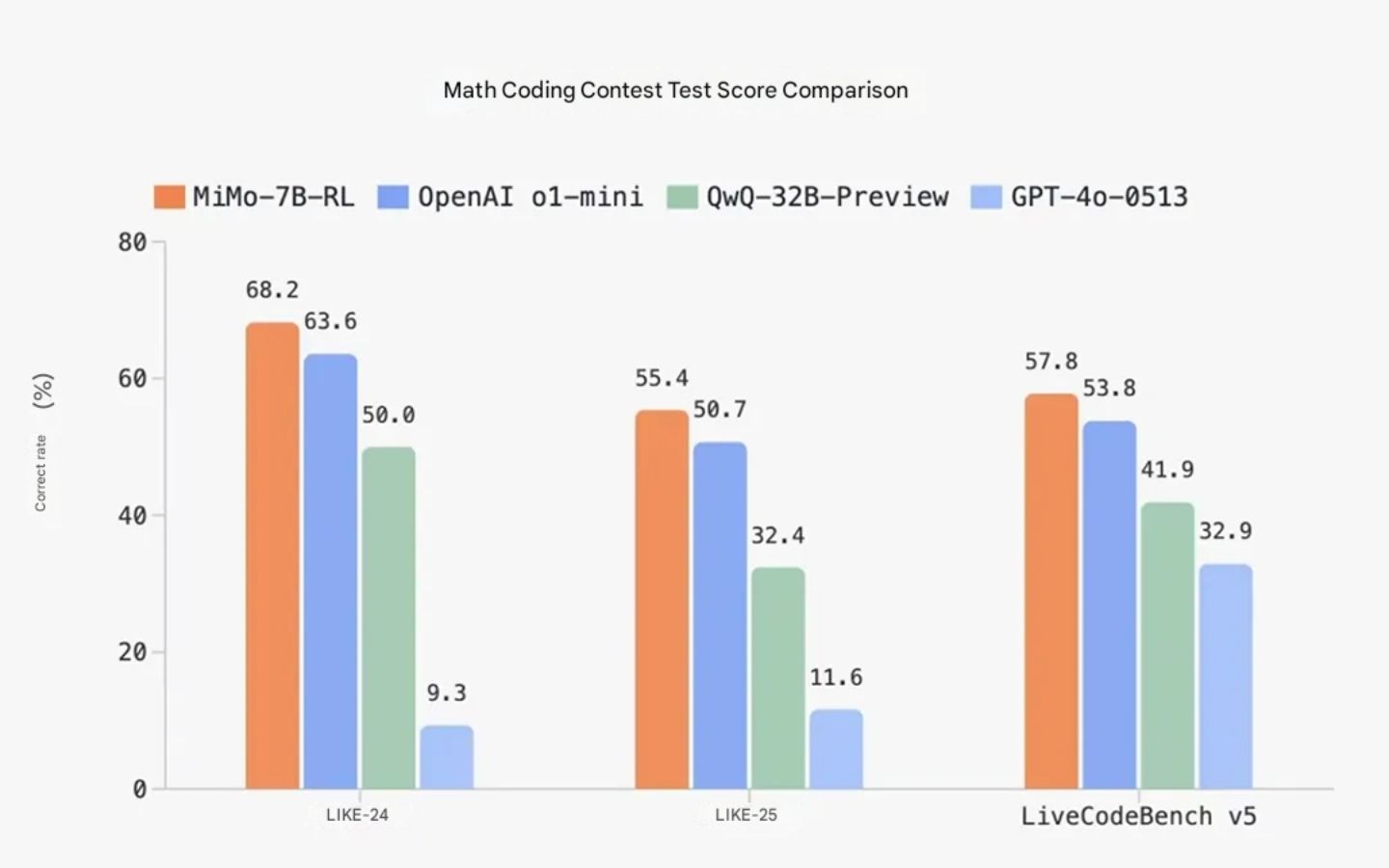

MiMo-7B sở hữu 7 tỷ tham số, quy mô nhỏ hơn đáng kể so với các “ông lớn” trên thị trường như GPT của OpenAI hay Qwen từ Alibaba. Tuy nhiên, theo tuyên bố của Xiaomi, mô hình này vẫn đủ sức cạnh tranh trực tiếp với các hệ thống tầm trung như o1-mini (OpenAI) và Qwen-32B-Preview (Alibaba), đặc biệt là trong các bài đánh giá về toán học và sinh mã, nơi MiMo-7B cho thấy khả năng suy luận vượt trội.

Nền tảng sức mạnh của MiMo-7B đến từ một quá trình huấn luyện kỹ lưỡng. Xiaomi cho biết họ đã sử dụng một tập dữ liệu “cô đọng” gồm 200 tỷ token thiên về logic và tư duy, đồng thời trải qua ba giai đoạn huấn luyện với tổng cộng 25 nghìn tỷ token.

Khác với cách tiếp cận truyền thống chỉ dự đoán token kế tiếp, MiMo-7B được thiết kế để dự đoán nhiều token cùng lúc, giúp tăng tốc suy diễn nhưng vẫn duy trì chất lượng đầu ra ổn định. Điều này đặc biệt hữu ích khi triển khai mô hình trong các môi trường yêu cầu hiệu suất thời gian thực như vLLM.

II. Cấu trúc, tối ưu hóa và hiệu suất nổi bật của MiMo-7B

Để nâng cao hiệu quả sau huấn luyện, Xiaomi áp dụng các kỹ thuật tiên tiến trong học tăng cường (Reinforcement Learning). Một điểm nổi bật là việc sử dụng thuật toán “Test Difficulty Driven Reward” – thiết kế riêng để giải quyết bài toán thiếu tín hiệu phần thưởng khi xử lý các tác vụ khó. Song song đó, chiến lược “Easy Data Re-Sampling” được triển khai nhằm giữ ổn định cho quá trình huấn luyện dài hơi.

Không chỉ dừng lại ở mô hình, Xiaomi còn chú trọng tối ưu hạ tầng huấn luyện. Với hệ thống “Seamless Rollout”, hãng giảm thiểu tối đa thời gian GPU không hoạt động trong các chu trình huấn luyện và kiểm thử, từ đó giúp tốc độ đào tạo tăng gấp 2,29 lần và hiệu suất đánh giá gần như gấp đôi – theo dữ liệu nội bộ của công ty.

MiMo-7B hiện được phát hành dưới 4 phiên bản:

- Base: mô hình gốc đã được huấn luyện sơ bộ.

- SFT: mô hình đã được tinh chỉnh thông qua dữ liệu có giám sát.

- RL-Zero: bản mở rộng từ Base, tích hợp học tăng cường.

- RL: phiên bản cao cấp nhất, phát triển từ SFT, được tối ưu sâu hơn và đạt độ chính xác cao nhất.

Xiaomi cũng công bố loạt kết quả benchmark để chứng minh năng lực của MiMo-7B:

- Trong toán học, MiMo-7B-RL đạt 95,8% trên bộ dữ liệu MATH-500 và 68% trên AIME 2024.

- Với tác vụ lập trình, mô hình đạt 57,8% trên LiveCodeBench v5 và gần 50% ở phiên bản v6.

- Ở mảng kiến thức tổng hợp (DROP, MMLU-Pro, GPQA), điểm số trung bình nằm trong khoảng 50+, rất ấn tượng đối với một mô hình chỉ 7B tham số.

II. Kết luận

Với việc ra mắt MiMo-7B – mô hình AI mã nguồn mở đầu tiên, Xiaomi cho thấy tham vọng rõ rệt trong việc gia nhập và cạnh tranh nghiêm túc trên thị trường trí tuệ nhân tạo. Đây không chỉ là bước tiến công nghệ, mà còn mở ra nhiều cơ hội để Xiaomi tích hợp AI sâu hơn vào hệ sinh thái sản phẩm của mình trong tương lai.

Bài viết có liên quan:

https%3A%2F%2Fphongvu.vn%2Fcong-nghe%2Fxiaomi-cong-bo-mo-hinh-ai-ma-nguon-mo%2F