Các mô hình ngôn ngữ lớn (LLM) đã phát triển đáng kể. Những gì bắt đầu như các công cụ tạo văn bản và dịch thuật đơn giản hiện đang được sử dụng trong nghiên cứu, ra quyết định và giải quyết vấn đề phức tạp. Một yếu tố chính trong sự thay đổi này là khả năng ngày càng tăng của LLM trong việc suy nghĩ có hệ thống hơn bằng cách chia nhỏ các vấn đề, đánh giá nhiều khả năng và tinh chỉnh phản hồi của chúng một cách năng động. Thay vì chỉ dự đoán từ tiếp theo trong một chuỗi, các mô hình này hiện có thể thực hiện lý luận có cấu trúc, giúp chúng hiệu quả hơn trong việc xử lý các tác vụ phức tạp. Các mô hình hàng đầu như O3 của OpenAI, Song Tử của Googlevà R1 của DeepSeek tích hợp những khả năng này để nâng cao khả năng xử lý và phân tích thông tin hiệu quả hơn.

Hiểu về suy nghĩ mô phỏng

Con người thường phân tích các lựa chọn khác nhau trước khi đưa ra quyết định. Cho dù là lập kế hoạch cho một kỳ nghỉ hay giải quyết một vấn đề, chúng ta thường mô phỏng các kế hoạch khác nhau trong tâm trí để đánh giá nhiều yếu tố, cân nhắc ưu và nhược điểm, và điều chỉnh các lựa chọn của mình cho phù hợp. Các nhà nghiên cứu đang tích hợp khả năng này vào LLM để nâng cao khả năng lý luận của họ. Ở đây, tư duy mô phỏng về cơ bản đề cập đến khả năng thực hiện lý luận có hệ thống của LLM trước khi đưa ra câu trả lời. Điều này trái ngược với việc chỉ đơn giản là lấy phản hồi từ dữ liệu đã lưu trữ. Một phép so sánh hữu ích là giải một bài toán:

- Một AI cơ bản có thể nhận ra một mẫu và nhanh chóng đưa ra câu trả lời mà không cần xác minh.

- Một AI sử dụng lý luận mô phỏng sẽ thực hiện từng bước, kiểm tra lỗi và xác nhận logic trước khi phản hồi.

Chuỗi suy nghĩ: Dạy AI suy nghĩ theo từng bước

Nếu LLM phải thực hiện suy nghĩ mô phỏng như con người, họ phải có khả năng chia nhỏ các vấn đề phức tạp thành các bước tuần tự nhỏ hơn. Đây là nơi Chuỗi suy nghĩ (CoT) kỹ thuật đóng vai trò quan trọng.

CoT là phương pháp thúc đẩy hướng dẫn LLM giải quyết vấn đề một cách có phương pháp. Thay vì vội vã đi đến kết luận, quy trình lý luận có cấu trúc này cho phép LLM chia các vấn đề phức tạp thành các bước đơn giản hơn, dễ quản lý hơn và giải quyết từng bước một.

Ví dụ, khi giải một bài toán bằng lời văn:

- AI cơ bản có thể cố gắng đối chiếu vấn đề với một ví dụ đã thấy trước đó và đưa ra câu trả lời.

- Một AI sử dụng lý luận Chuỗi suy nghĩ sẽ phác thảo từng bước, xử lý logic các phép tính trước khi đưa ra giải pháp cuối cùng.

Cách tiếp cận này hiệu quả trong các lĩnh vực đòi hỏi suy luận logic, giải quyết vấn đề nhiều bước và hiểu biết theo ngữ cảnh. Trong khi các mô hình trước đó yêu cầu chuỗi lý luận do con người cung cấp, các LLM tiên tiến như O3 của OpenAI và R1 của DeepSeek có thể học và áp dụng lý luận CoT một cách thích ứng.

Các LLM hàng đầu triển khai tư duy mô phỏng như thế nào

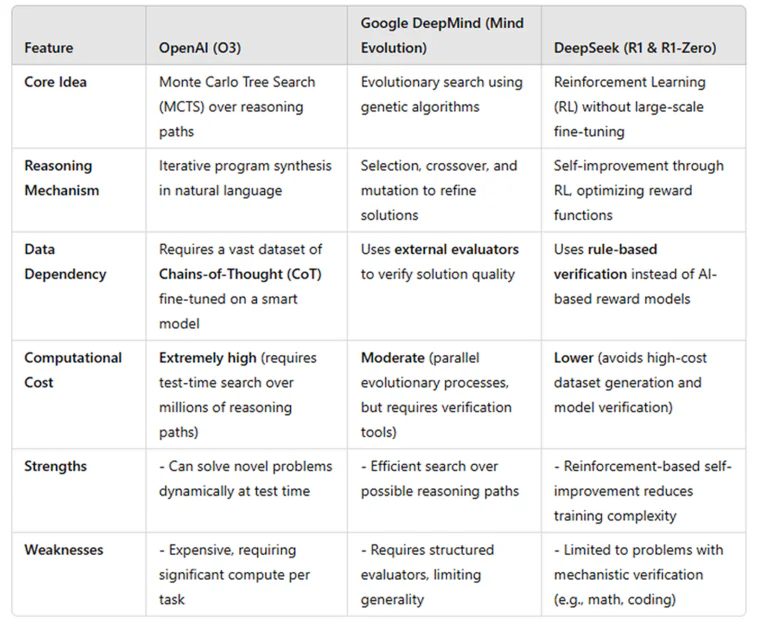

Các LLM khác nhau đang sử dụng tư duy mô phỏng theo những cách khác nhau. Dưới đây là tổng quan về cách O3 của OpenAI, các mô hình của Google DeepMind và DeepSeek-R1 thực hiện tư duy mô phỏng, cùng với các điểm mạnh và hạn chế tương ứng của chúng.

OpenAI O3: Suy nghĩ trước như một kỳ thủ cờ vua

Trong khi thông tin chi tiết chính xác về mô hình O3 của OpenAI vẫn chưa được tiết lộ, nhà nghiên cứu Tin nó sử dụng một kỹ thuật tương tự như Tìm kiếm cây Monte Carlo (MCTS), một chiến lược được sử dụng trong các trò chơi do AI điều khiển như AlphaGo. Giống như một người chơi cờ vua phân tích nhiều nước đi trước khi quyết định, O3 khám phá nhiều giải pháp khác nhau, đánh giá chất lượng của chúng và chọn ra giải pháp triển vọng nhất.

Không giống như các mô hình trước đó dựa vào nhận dạng mẫu, O3 chủ động tạo và tinh chỉnh các đường dẫn lý luận bằng các kỹ thuật CoT. Trong quá trình suy luận, nó thực hiện các bước tính toán bổ sung để xây dựng nhiều chuỗi lý luận. Sau đó, chúng được đánh giá bởi một mô hình đánh giá—có thể là một mô hình phần thưởng được đào tạo để đảm bảo tính nhất quán và tính chính xác về mặt logic. Phản hồi cuối cùng được lựa chọn dựa trên cơ chế chấm điểm để cung cấp đầu ra có lý luận tốt.

O3 tuân theo một quy trình nhiều bước có cấu trúc. Ban đầu, nó được tinh chỉnh trên một tập dữ liệu lớn về các chuỗi lý luận của con người, nội tâm hóa các mô hình tư duy logic. Tại thời điểm suy luận, nó tạo ra nhiều giải pháp cho một vấn đề nhất định, xếp hạng chúng dựa trên tính chính xác và tính mạch lạc, và tinh chỉnh giải pháp tốt nhất nếu cần. Mặc dù phương pháp này cho phép O3 tự sửa trước khi phản hồi và cải thiện độ chính xác, nhưng sự đánh đổi là chi phí tính toán – việc khám phá nhiều khả năng đòi hỏi sức mạnh xử lý đáng kể, khiến nó chậm hơn và tốn nhiều tài nguyên hơn. Tuy nhiên, O3 vượt trội về phân tích động và giải quyết vấn đề, đưa nó vào vị trí trong số các mô hình AI tiên tiến nhất hiện nay.

Google DeepMind: Tinh chỉnh câu trả lời như một biên tập viên

DeepMind đã phát triển một phương pháp tiếp cận mới được gọi là “sự tiến hóa của tâm trí”, coi lý luận như một quá trình tinh chỉnh lặp đi lặp lại. Thay vì phân tích nhiều kịch bản tương lai, mô hình này hoạt động giống như một biên tập viên tinh chỉnh nhiều bản thảo khác nhau của một bài luận. Mô hình tạo ra một số câu trả lời khả thi, đánh giá chất lượng của chúng và tinh chỉnh câu trả lời tốt nhất.

Lấy cảm hứng từ thuật toán di truyền, quy trình này đảm bảo phản hồi chất lượng cao thông qua lặp lại. Nó đặc biệt hiệu quả đối với các nhiệm vụ có cấu trúc như câu đố logic và thử thách lập trình, trong đó các tiêu chí rõ ràng xác định câu trả lời tốt nhất.

Tuy nhiên, phương pháp này có những hạn chế. Vì nó dựa vào hệ thống chấm điểm bên ngoài để đánh giá chất lượng phản hồi, nên nó có thể gặp khó khăn với lý luận trừu tượng không có câu trả lời đúng hay sai rõ ràng. Không giống như O3, lý luận động theo thời gian thực, mô hình của DeepMind tập trung vào việc tinh chỉnh các câu trả lời hiện có, khiến nó kém linh hoạt hơn đối với các câu hỏi mở.

DeepSeek-R1: Học cách lý luận như một sinh viên

DeepSeek-R1 sử dụng phương pháp tiếp cận dựa trên học tăng cường cho phép phát triển khả năng lý luận theo thời gian thay vì đánh giá nhiều phản hồi theo thời gian thực. Thay vì dựa vào dữ liệu lý luận được tạo trước, DeepSeek-R1 học bằng cách giải quyết vấn đề, nhận phản hồi và cải thiện theo từng bước lặp lại—tương tự như cách học sinh tinh chỉnh kỹ năng giải quyết vấn đề của mình thông qua thực hành.

Mô hình tuân theo một vòng lặp học tăng cường có cấu trúc. Nó bắt đầu với một mô hình cơ sở, chẳng hạn như DeepSeek-V3, và được nhắc giải quyết các bài toán từng bước. Mỗi câu trả lời được xác minh thông qua thực thi mã trực tiếp, bỏ qua nhu cầu về một mô hình bổ sung để xác thực tính chính xác. Nếu giải pháp đúng, mô hình sẽ được thưởng; nếu không đúng, mô hình sẽ bị phạt. Quá trình này được lặp lại rộng rãi, cho phép DeepSeek-R1 tinh chỉnh các kỹ năng suy luận logic của mình và ưu tiên các vấn đề phức tạp hơn theo thời gian.

Một lợi thế chính của phương pháp này là hiệu quả. Không giống như O3, thực hiện suy luận mở rộng tại thời điểm suy luận, DeepSeek-R1 nhúng các khả năng suy luận trong quá trình đào tạo, giúp nó nhanh hơn và tiết kiệm chi phí hơn. Nó có khả năng mở rộng cao vì không yêu cầu tập dữ liệu được gắn nhãn lớn hoặc mô hình xác minh tốn kém.

Tuy nhiên, cách tiếp cận dựa trên học tăng cường này có những đánh đổi. Vì nó dựa vào các nhiệm vụ có kết quả có thể xác minh được, nên nó vượt trội về toán học và mã hóa. Tuy nhiên, nó có thể gặp khó khăn với lý luận trừu tượng trong luật pháp, đạo đức hoặc giải quyết vấn đề sáng tạo. Trong khi lý luận toán học có thể chuyển sang các lĩnh vực khác, khả năng áp dụng rộng hơn của nó vẫn chưa chắc chắn.

Bàn: So sánh giữa O3 của OpenAI, Mind Evolution của DeepMind và R1 của DeepSeek

Tương lai của lý luận AI

Lý luận mô phỏng là một bước tiến quan trọng hướng tới việc khiến AI trở nên đáng tin cậy và thông minh hơn. Khi các mô hình này phát triển, trọng tâm sẽ chuyển từ việc chỉ tạo văn bản sang phát triển khả năng giải quyết vấn đề mạnh mẽ gần giống với tư duy của con người. Những tiến bộ trong tương lai có thể sẽ tập trung vào việc tạo ra các mô hình AI có khả năng xác định và sửa lỗi, tích hợp chúng với các công cụ bên ngoài để xác minh phản hồi và nhận ra sự không chắc chắn khi đối mặt với thông tin mơ hồ. Tuy nhiên, một thách thức chính là cân bằng độ sâu của lý luận với hiệu quả tính toán. Mục tiêu cuối cùng là phát triển các hệ thống AI cân nhắc kỹ lưỡng các phản hồi của chúng, đảm bảo độ chính xác và độ tin cậy, giống như một chuyên gia con người đánh giá cẩn thận từng quyết định trước khi hành động.

https%3A%2F%2Fwww.unite.ai%2Fvi%2Ft%25E1%25BB%25AB-openais-o3-%25C4%2591%25E1%25BA%25BFn-deepseeks-r1-c%25C3%25A1ch-suy-ngh%25C4%25A9-m%25C3%25B4-ph%25E1%25BB%258Fng-%25C4%2591ang-khi%25E1%25BA%25BFn-llms-suy-ngh%25C4%25A9-s%25C3%25A2u-s%25E1%25BA%25AFc-h%25C6%25A1n%2F