Thương mại điện tử đã phát triển trở thành một phần không thể thiếu trong nền kinh tế toàn cầu. Amazon – một trong những nền tảng mua sắm trực tuyến hàng đầu – ghi nhận hàng triệu bình luận đánh giá về sản phẩm mỗi năm.

TS. Nguyễn Thị Hồng Duyên

Khoa Kế toán – Kiểm toán, Trường Đại học Công nghiệp Hà Nội

Vũ Thị Hồng Ánh, Đồng Phương Duyên

Nguyễn Thị Thu Thuỷ, Phạm Minh Triết, Phạm Thị Thu Trà

Sinh viên chuyên ngành phân tích dữ liệu kinh doanh, Trường Đại học Công nghiệp Hà Nội

Email: Honganhvt59@gmail.com

Tóm tắt

Nghiên cứu đề xuất ứng dụng mô hình RoBERTa và phương pháp phân loại đa nhãn để khai thác hiệu quả các chủ đề trong đánh giá sách của người dùng trên Amazon. Dữ liệu được gán nhãn tự động bằng kỹ thuật zero-shot classification, sau đó được huấn luyện với mô hình RoBERTa. Kết quả thực nghiệm cho thấy, mô hình đạt F1-score trung bình 0.95 và thể hiện hiệu suất vượt trội ở các chủ đề như: nội dung, đề xuất và chất lượng in ấn. Mô hình không chỉ đảm bảo độ chính xác cao, mà còn thể hiện khả năng bao quát tốt trong xử lý ngữ cảnh đa dạng của người dùng, khẳng định tính hiệu quả và tiềm năng ứng dụng trong khai thác phản hồi khách hàng trên các nền tảng thương mại điện tử.

Từ khóa: Amazon, phân loại chủ đề, RoBERTa, thương mại điện tử

Summary

This study proposes the application of the RoBERTa model and multi-label classification methods to effectively extract thematic information from user book reviews on Amazon. The dataset was automatically labeled by the zero-shot classification and subsequently fine-tuned with the RoBERTa model. Experimental results show that the model achieved an average F1-score of 0.95 and demonstrated superior performance in topics such as content, recommendations, and print quality. The model not only ensures high accuracy but also exhibits strong contextual coverage in handling the diverse language used by users, highlighting its effectiveness and potential for application in customer feedback analysis on e-commerce platforms.

Keywords: Amazon, topic classification, RoBERTa, e-commerce

GIỚI THIỆU

Thương mại điện tử (TMĐT) đã phát triển trở thành một phần không thể thiếu trong nền kinh tế toàn cầu. Amazon – một trong những nền tảng mua sắm trực tuyến hàng đầu – ghi nhận hàng triệu bình luận đánh giá về sản phẩm mỗi năm. Những bình luận đóng vai trò quan trọng trong việc định hình quyết định mua sắm của người dùng khác cũng như chiến lược kinh doanh của các nhà bán hàng. Tuy nhiên, các phương pháp truyền thống – dựa vào quy tắc hoặc xử lý thống kê đơn giản (ví dụ: phân tích từ khóa), thường không đủ khả năng nhận diện các biểu hiện tinh tế như: ẩn dụ, mâu thuẫn, hoặc ngữ cảnh văn hóa đặc thù. Nghiên cứu của Blei và cộng sự (2003) đã sử dụng mô hình Latent Dirichlet Allocation (LDA) để trích xuất chủ đề từ các tập văn bản lớn, nhưng còn khó khăn khi xử lý văn bản ngắn. RoBERTa, một biến thể cải tiến của BERT (Liu và cộng sự, 2019), cho hiệu suất vượt trội trong nhiều tác vụ NLP, nhưng ứng dụng vào phân loại chủ đề bình luận TMĐT còn hạn chế về quy mô dữ liệu và độ sâu phân tích. Do đó, nghiên cứu này tập trung sử dụng mô hình RoBERTa để phát triển một phương pháp phân loại chủ đề chính từ các bình luận khách hàng trên Amazon nhằm hỗ trợ trong việc định hướng cải tiến sản phẩm và tối ưu hóa trải nghiệm khách hàng.

TỔNG QUAN NGHIÊN CỨU

Thương mại điện tử

TMĐT (E-commerce) là hình thức trao đổi, mua bán hàng hóa và dịch vụ thông qua nền tảng trực tuyến. Trong bối cảnh chuyển đổi số toàn cầu, TMĐT đã trở thành trụ cột của nền kinh tế hiện đại, giúp định hình lại hành vi tiêu dùng, mô hình kinh doanh. Theo Bawack và cộng sự (2022), sự phát triển mạnh mẽ của TMĐT được thúc đẩy bởi sự phổ cập của internet, sự gia tăng thiết bị di động thông minh và tiến bộ trong công nghệ thanh toán số. Các mô hình TMĐT phát triển mạnh mẽ nhờ khả năng phục vụ trực tiếp người tiêu dùng với sự thuận tiện, đa dạng sản phẩm và dịch vụ đi kèm. Một yếu tố then chốt thúc đẩy hiệu quả hoạt động của TMĐT hiện đại là việc tích hợp AI để cá nhân hóa trải nghiệm mua sắm, dự báo nhu cầu, tối ưu hóa chuỗi cung ứng và đảm bảo an ninh dữ liệu (Bawack và cộng sự, 2022). Amazon – một ví dụ điển hình cho việc ứng dụng AI và công nghệ dữ liệu lớn để nâng cao hiệu quả kinh doanh. Từ khởi điểm là cửa hàng sách trực tuyến năm 1994, Amazon đã phát triển thành hệ sinh thái số toàn diện (Grandon và Pearson, 2004) và hiện sở hữu kho dữ liệu người dùng khổng lồ, đặc biệt là từ các đánh giá sản phẩm. Các đánh giá này, dưới dạng văn bản, hình ảnh, video, tạo ra nguồn dữ liệu phi cấu trúc. Đối với ngành hàng sách, dữ liệu đánh giá còn mang ý nghĩa phản ánh nhu cầu, cảm nhận và xu hướng tiêu dùng trong cộng đồng độc giả. Trong bối cảnh dữ liệu văn bản ngày càng phong phú và phức tạp, việc xác định và trích xuất các chủ đề chính trở thành hướng nghiên cứu quan trọng, góp phần ứng dụng hiệu quả các kỹ thuật xử lý ngôn ngữ tự nhiên trong TMĐT.

Topic Modeling

Topic modeling là một nhánh nghiên cứu khai phá văn bản (text mining) và xử lý ngôn ngữ tự nhiên (NLP), nhằm trích xuất các chủ đề tiềm ẩn trong một tập dữ liệu chưa được gán nhãn trước đó. Mỗi tài liệu được xem là sự kết hợp của nhiều chủ đề, và mỗi chủ đề được biểu diễn bằng một nhóm từ khóa đặc trưng. Phương pháp này hữu ích trong việc phân tích dữ liệu văn bản phức tạp, như tài liệu khoa học hay bình luận khách hàng (Blei và cộng sự, 2003). LDA là một phương pháp phổ biến trong top modeling, sử dụng phân phối Dirichlet để trích xuất chủ đề, nhưng yêu cầu xác định số chủ đề trước và kém hiệu quả với văn bản ngắn, thiếu ngữ cảnh (Blei và cộng sự, 2003). Trong khi đó, Non-negative Matrix Factorization (NMF) phân rã ma trận để trích xuất thành phần không âm, phù hợp với dữ liệu tuyến tính.

Thách thức này đã thúc đẩy sự ra đời của các phương pháp topic modeling hiện đại, kết hợp kỹ thuật biểu diễn ngữ nghĩa bằng vector (word embedding hoặc document embedding) với các thuật toán phân cụm và khai phá chủ đề ngữ nghĩa sâu. Những phương pháp này chứng tỏ hiệu quả vượt trội trong việc xử lý văn bản ngắn, phân tách rõ ràng các chủ đề trùng lặp và cải thiện khả năng giải thích của kết quả đầu ra. Trong bối cảnh đó, các mô hình topic modeling hiện đại đang dần trở thành xu hướng thay thế hợp lý và hiệu quả hơn so với các phương pháp truyền thống.

RoBERTa (Robustly Optimized BERT Pretraining Approach)

RoBERTa là một mô hình tiên tiến được đề xuất bởi Facebook AI vào năm 2019. Mô hình này được xây dựng dựa trên kiến trúc của BERT tuy nhiên lại có nhiều cải tiến hơn trong quá trình huấn luyện nhằm nâng cao hiệu suất mô hình (Liu và cộng sự, 2019). Giống như BERT, RoBERTa sử dụng kiến trúc Transformer đa lớp và cơ chế tự chú ý (self-attention) nhưng điểm khác biệt quan trọng nằm ở cách thức huấn luyện và xử lý dữ liệu đầu vào. RoBERTa đã loại bỏ nhiệm vụ dự đoán câu tiếp theo (Next Sentence Prediction) – một trong hai nhiệm vụ quan trọng trong BERT – và chỉ tập trung vào nhiệm vụ Masked Language Modeling (MLM). Đặc biệt, thay vì sử dụng Static Masking (mask một lần duy nhất cho đối tượng) như BERT, RoBERTa sử dụng Dynamic Masking, tức là các từ bị che sẽ được chọn ngẫu nhiên trong từng batch huấn luyện. Nhờ vậy, mô hình thấy được nhiều khía cạnh khác nhau của ngữ cảnh, chứ không bị bó buộc vào một cách học cố định như BERT, từ đó nâng cao khả năng hiểu ngôn ngữ (Joshy và Sundar, 2022).

RoBERTa được huấn luyện trên tập dữ liệu văn bản quy mô lớn (160GB), vì vậy mà mô hình vượt trội hơn về khả năng hiểu ngữ nghĩa và cấu trúc ngôn ngữ trong các tác vụ như phân tích cảm xúc, phân loại văn bản và phát hiện tin đồn (Wang và cộng sự, 2023). RoBERTa có khả năng tổng quát hóa tốt hơn đối với các từ mới hoặc hiếm gặp nhờ sở hữu bộ từ vựng mở rộng (lên tới hơn 50.000 từ). Bên cạnh đó, trong quá trình tinh chỉnh (fine-tuning), RoBERTa còn có thể kết hợp với các kỹ thuật học nâng cao như học đa nhiệm (multi-task learning) và học chuyển tiếp (migration learning) để cải thiện hiệu suất cho từng tác vụ cụ thể (Timoneda và Vera, 2025).

RoBERTa là một mô hình học sâu thể hiện hiệu suất vượt trội trên nhiều tác vụ xử lý ngôn ngữ tự nhiên, đặc biệt trong bối cảnh yêu cầu về độ chính xác và khả năng thích ứng ngày càng cao đối với các mô hình ngôn ngữ hiện đại.

PHƯƠNG PHÁP NGHIÊN CỨU

Nghiên cứu được tiến hành trên bộ dữ liệu gồm 15,000 phản hồi của khách hàng về sản phẩm sách. Để giải quyết bài toán thiếu nhãn dữ liệu, nhóm đã áp dụng mô hình zero-shot classification facebook/bart-large-mnli để gán nhãn tự động. Mỗi phản hồi được đánh giá dựa trên sáu nhãn ứng viên: “price”, “print_quality”, “content”, “delivery”, “buy_again”, và “recommend”. Một nhãn được gán cho phản hồi nếu xác suất của nó vượt ngưỡng 0.5, từ đó tạo ra một ma trận nhãn giả đa nhãn làm cơ sở cho việc huấn luyện mô hình phân loại (Bài viết sử dụng cách viết số thập phân theo chuẩn quốc tế).

Trong quá trình phân tích ban đầu, nhóm nhận thấy 2 chủ đề “price” và “delivery” xuất hiện với tần suất thấp, gây ra tình trạng mất cân bằng dữ liệu. Để khắc phục vấn đề này, phương pháp oversampling đã được áp dụng bằng cách nhân đôi ngẫu nhiên các mẫu thuộc hai lớp thiểu số này. Sau khi cân bằng, toàn bộ dữ liệu được chia ngẫu nhiên thành ba tập: huấn luyện (64%), xác thực (16%) và kiểm thử (20%) để chuẩn bị cho bước tiếp theo. Nhóm đã sử dụng mô hình RobertaForSequenceClassification và tinh chỉnh (fine-tuning) trên GPU. Các bình luận được mã hóa thành chuỗi token có độ dài tối đa 128. Quá trình huấn luyện kéo dài 5 epochs với bộ tối ưu AdamW (learning rate 1e-5) và hàm mất mát Binary Cross-Entropy, phù hợp cho bài toán đa nhãn. Để tránh overfitting và chọn ra mô hình tốt nhất, kết quả được ghi nhận mỗi 200 bước và so sánh chỉ số F1-macro trên tập xác thực để lưu lại checkpoint hiệu quả nhất.

Sau khi hoàn tất huấn luyện, mô hình được đánh giá toàn diện trên tập kiểm thử. Các chỉ số chính bao gồm Precision, Recall, F1-score và Hamming Loss được sử dụng để đo lường độ chính xác. Để kết quả trở nên trực quan, nhóm đã sử dụng biểu đồ cột để so sánh hiệu suất trên từng nhãn, ma trận nhầm lẫn dạng heatmap để phân tích chi tiết các lỗi phân loại, cùng các biểu đồ tròn và cột để minh họa tỷ lệ dự đoán của mỗi chủ đề. Cách tiếp cận này giúp đánh giá sâu sắc và diễn giải kết quả một cách sinh động.

KẾT QUẢ NGHIÊN CỨU

Sau khi tiến hành huấn luyện, mô hình RoBERTa trên tập dữ liệu đánh giá sản phẩm sách từ Amazon, bước tiếp theo là đánh giá hiệu suất phân loại của mô hình.

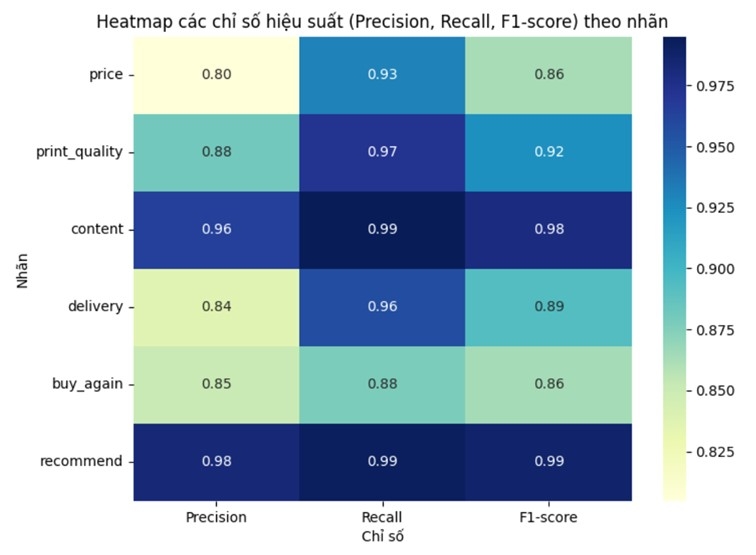

Hình 1: Heatmap các chỉ số hiệu suất theo từng chủ đề

|

Nguồn: Tổng hợp kết quả từ nhóm tác giả

Báo cáo phân loại (Hình 1) cho thấy, độ chính xác (Precision) dao động từ 0.80 đến 0.98 và độ nhạy (Recall) từ 0.88 đến 0.99. Khi kết hợp hai chỉ số này, F1‑score trung bình của toàn bộ sáu nhãn đạt 0.95, khẳng định mô hình vừa chính xác vừa ổn định. Đặc biệt, các nhãn liên quan đến “content” và “recommend” ghi nhận F1‑score rất cao (≥ 0.98), thể hiện RoBERTa vượt trội trong việc nhận diện nội dung chính và đề xuất sản phẩm. Ngược lại, nhãn “price” và “buy_again” có F1‑score thấp hơn một chút (0.86). Nhìn chung, kết quả này khẳng định RoBERTa không chỉ đáp ứng tốt yêu cầu về độ chính xác cao mà còn có khả năng bao quát ngữ cảnh đa dạng, mở ra triển vọng ứng dụng rộng rãi trong khai thác phản hồi khách hàng trên nền tảng TMĐT.

Để kiểm chứng kết quả và khả năng nhận diện chủ đề của mô hình RoBERTa đã được huấn luyện, một quan sát gồm 5 bình luận tích cực được chọn ngẫu nhiên trong tập test (Hình 2)

Hình 2: Kết quả phân loại chủ đề từ đánh giá

|

Nguồn: Tổng hợp kết quả từ nhóm tác giả

Kết quả dự đoán của mô hình trên một số bình luận tích cực cho thấy, khả năng nhận diện chủ đề của mô hình khá chính xác và phù hợp với nội dung phản hồi của người dùng. Cụ thể, với các bình luận chứa thông tin chi tiết về trải nghiệm đọc sách, mô hình có thể xác định đồng thời nhiều chủ đề như chất lượng in ấn (print_quality), nội dung sách (content), thời gian giao hàng (delivery), khả năng mua lại (buy_again), giá cả (price) và mức độ đề xuất sản phẩm (recommend). Ngay cả với những phản hồi ngắn gọn hoặc mang tính biểu cảm cao, mô hình vẫn dự đoán được các chủ đề liên quan một cách hợp lý (Hình 2). Điều này cho thấy, mô hình có khả năng hiểu ngữ cảnh tốt, có thể thích ứng với các dạng biểu đạt khác nhau của người dùng dù nội dung đánh giá có sự khác biệt về cách diễn đạt hay độ dài, mô hình vẫn nhận diện đúng các chủ đề liên quan với độ nhất quán cao.

Bên cạnh việc đánh giá hiệu suất phân loại của mô hình, nhóm nghiên cứu cũng tiến hành phân tích phân bố chủ đề trong các phản hồi tích cực để làm rõ số lượng xuất hiện tương đối của từng nhãn.

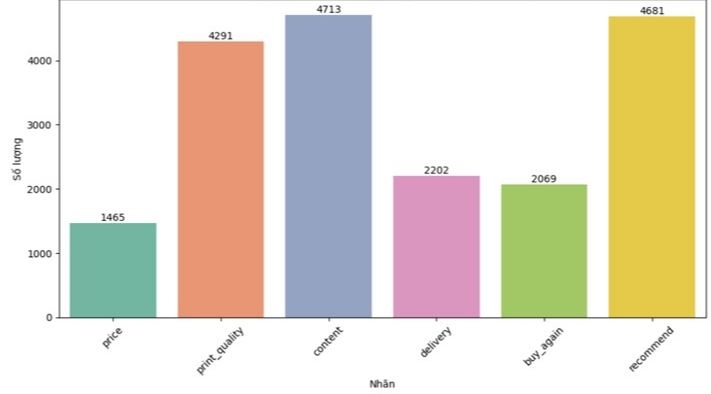

Hình 3: Số lượng mỗi chủ đề trong tổng số bình luận tích cực

|

Nguồn: Tổng hợp kết quả từ nhóm tác giả

Dữ liệu Hình 3 thể hiện số lượng các phản hồi tích cực được mô hình RoBERTa gán nhãn theo từng chủ đề cụ thể, từ đó cung cấp cái nhìn định lượng về mức độ xuất hiện của mỗi nội dung được người dùng đề cập. Cụ thể, “content” là chủ đề chiếm ưu thế với 4,713 phản hồi, chiếm khoảng 24.3% tổng số phản hồi tích cực. Theo sát là “recommend” với 4,681 phản hồi (24.1%). Chủ đề “print_quality” cũng được đề cập nhiều, với 4,291 phản hồi (22.1%), phản ánh sự quan tâm của người dùng đến yếu tố chất lượng trình bày và in ấn. Ngược lại, các chủ đề như “delivery” (2,202 phản hồi, tương đương 11.3%), “buy_again” (2,069 phản hồi, 10.7%) và “price” (1,465 phản hồi, 7.5%) xuất hiện với tần suất thấp hơn trong nhóm phản hồi tích cực.

KẾT LUẬN

Kết quả thực nghiệm cho thấy, mô hình đạt F1-score trung bình 0.95, thể hiện độ chính xác cao và khả năng tổng quát hóa tốt trong việc nhận diện các chủ đề như nội dung, chất lượng in ấn, giao hàng, giá cả và mức độ đề xuất sản phẩm. Điều này góp phần hỗ trợ doanh nghiệp nâng cao chất lượng sản phẩm và dịch vụ và tối ưu trải nghiệm người dùng.

Tuy nhiên, nghiên cứu vẫn tồn tại một số hạn chế cần tiếp tục được cải thiện. Mô hình RoBERTa chưa được so sánh trực tiếp với các mô hình ngôn ngữ tiên tiến, khiến việc đánh giá toàn diện hiệu suất còn chưa đầy đủ. Tập dữ liệu đánh giá chỉ tập trung vào ngành sách, chưa bao quát được nhiều ngành hàng khác để kiểm chứng tính khái quát hóa. Những hạn chế này mở ra các hướng nghiên cứu tiếp theo, trong đó có thể mở rộng phạm vi dữ liệu, áp dụng mô hình trên nhiều lĩnh vực khác nhau và so sánh hiệu quả giữa các mô hình hiện đại. Những hướng phát triển này không chỉ gia tăng giá trị thực tiễn của nghiên cứu mà còn góp phần thúc đẩy ứng dụng AI vào phân tích phản hồi khách hàng trong kỷ nguyên dữ liệu lớn./.

TÀI LIỆU THAM KHẢO

1. Bawack, R. E., Wamba, S. F., and Carillo, K. D. A. (2022). Artificial Intelligence in e-commerce: A bibliometric analysis and research agenda, Electronic Markets, 32(1), 23-42.

2. Blei, D. M., Ng, A. Y., and Jordan, M. I. (2003). Latent Dirichlet Allocation, Journal of Machine Learning Research, 3.

3. Grandon, E. E., and Pearson, J. M. (2004). Electronic commerce adoption: an empirical study of small and medium US businesses, Information and management, 42(1), 197-216.

3. Joshy, A., and Sundar, S. (2022, December). Analyzing the performance of sentiment analysis using BERT, DistilBERT, and RoBERTa, In 2022 IEEE international power and renewable energy conference (IPRECON) (pp. 1-6), IEEE.

3. Liu, Y., Ott, M., Goyal, N., Du, J., Joshi, M., Chen, D., … and Stoyanov, V. (2019). Roberta: A robustly optimized bert pretraining approach, arXiv preprint arXiv:1907.11692.

4. Mo, Y., Li, S., Dong, Y., Zhu, Z., and Li, Z. (2024). Password complexity prediction based on RoBERTa algorithm, Applied Science and Engineering Journal for Advanced Research, 3(3), 1-5.

5. Timoneda, J. C., and Vera, S. V. (2025). BERT, RoBERTa or DeBERTa? Comparing performance across transformers models in political science text, The Journal of Politics, 87(1).

6. Wang, Z., Cheng, J., Cui, C., and Yu, C. (2023). Implementing BERT and fine-tuned RoBERTa to detect AI generated news by ChatGPT, arXiv preprint arXiv:2306.07401.

Ngày nhận bài: 20/4/2025; Ngày hoàn thiện biên tập: 14/6/2025; Ngày duyệt đăng: 23/6/2025 |

https%3A%2F%2Fkinhtevadubao.vn%2Fung-dung-mo-hinh-roberta-xac-dinh-chu-de-trong-cac-danh-gia-cua-khach-hang-ve-san-pham-sach-tren-san-thuong-mai-dien-tu-amazon-31655.html